#人工智能 有开发者在配备 512GB 内存 / M3 Ultra 芯片的 Mac Studio 上运行 DeepSeek 最新模型 V3-0324-685B 版,速率为 20toks/s。Mac Studio 仍然属于消费级产品 (虽然这个配置售价 9499 美元),但 DeepSeek 的新模型能够本地运行且速率还不错也非常让人惊讶。查看全文:https://ourl.co/108521

昨天夜里 DeepSeek 推出 V3 模型的 0324 更新,DeepSeek 自称这只是一次小型更新,但不少开发者经过测试后发现新版本较之前的 V3 模型有着巨大的能力提升,简单来说其能力甚至超过 Claude 3.5 Sonnet 模型。

DeepSeek-V3-0324 模型也同样遵循 DeepSeek 的开源策略,该模型采用非常宽松的 MIT 许可证,无论是个人还是企业都可以免费使用并且可以基于该模型开发衍生产品。

尽管这次更新在人工智能领域引起很多关注,但 DeepSeek 的低调还是让人有些惊讶,正如文章开头所说 DeepSeek 自称这只是一次小型更新。

科技网站 Venturebeat 表示:

这个拥有 685B 参数的模型没有附带任何白皮书、博客文章或营销宣传,只有一个空白的 README 文件和模型权重本身。这种方法与其他 AI 公司典型的精心策划的产品发布形成鲜明对比,这些 AI 公司的产品发布会通常会在实际发布之前进行数月的宣传。

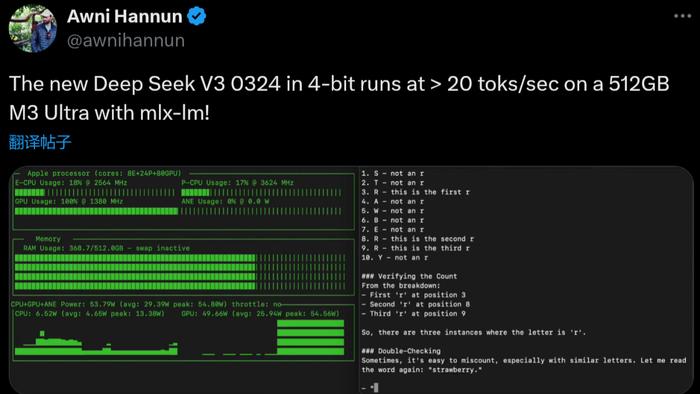

目前在网上已经有很多文章介绍 DeepSeek-V3-0324 的能力和对比测试,不过在 X/Twitter 上开发者 @Awnihannun 发布的帖子更引人关注,因为这位开发者在自己的 Mac Studio 本地运行了 DeepSeek-V3-0324 模型。

具体来说这位开发者使用的是配备 512GB 内存和搭载 M3 Ultra 芯片的 Mac Studio,使用 Python 开源库 MLX-LM 用于在 Apple M 芯片上生成文本和微调大型语言模型,实际运行 0324 模型时以每秒 20 个 tokens 输出数据。

要知道 @Awnihannun 运行的并非精简版模型,而是 DeepSeek-V3-0324 完整的 685B 参数版,能够在 512GB 内存的消费级产品上运行并提供不错的速率是个非常巨大的进步。

当然这个售价高达 9499 美元的 Mac Studio 可能与消费级产品有些距离,不过未来相信我们的比较普通的消费级产品也应该可以运行这类超大规模的语言模型。

举报成功